哪些股票可融资 美政府欲阻天网降临,GPT-5先做末日测试

据招股书透露,嘀嗒出行为中国第二大顺风车平台,顺风车交易总额为人民币61亿元(单位:下同),截至2023年6月30日,在全国366个城市提供基于App的顺风车平台服务,拥有约1520万名认证私家车车主,为6360万名顺风车乘客提供服务。

另据羊城晚报,近日,有“旅游达人”之称的项明生在社交平台晒出与曾志伟的合照,他透露曾志伟一周前来台北做手术。照片中,术后的曾志伟气色红润,精神不错,合影中露出招牌笑容。

编辑:乔杨 好困

【新智元导读】不到一年时间实现活跃用户数量翻倍的OpenAI正是炙手可热,但最近因为和Anthropic共同签署了一项政府安全协议又卷入非议。加上最近的SB 1047法案,AI安全领域正是沸反盈天。

虽然OpenAI经常被曝出财务状况不佳,5月就发布的Her也一直鸽到现在,但这些都不影响他们的「顶流」地位。

不仅最近要开启新一轮融资,而且活跃用户数相比去年11月已经增长了一倍,每周有超过2亿人使用ChatGPT。

虽然2022年底ChatGPT推出后,谷歌、微软和Meta都推出了各自的AI聊天应用,纷纷要在这个竞争激烈的市场中分一杯羹,但OpenAI的用户数量依旧不断增长。

根据The Information今天的报道,Meta的AI助手拥有4000万日活跃用户、至少4亿月活跃用户,相比OpenAI还是有不小的差距。

除了个人用户,OpenAI还表示,92%的财富500强公司正在使用他们的产品。自7月份GPT-4o mini模型发布以来,API的使用量也翻了一番。

5月份的时候,GPT-4o刚发布,四大会计事务所之一普华永道就和OpenAI达成了合作协议,成为了ChatGPT的「经销商」,负责将相关软件转售给其他企业,10万名普华永道员工也将在工作中使用ChatGPT。

此外,Salesforce、Snap、Quizlet、Shopify等科技公司也和OpenAI展开了合作,以OpenAI提供的API为基础,或者与ChatGPT进行整合,构建自己的AI功能,涉及的应用程序包括Slack、SnapChat、Shopify等。

管理咨询巨头Bain也表示,他们与OpenAI合作,将包括ChatGPT在内的技术集成到自己开发的管理系统、研究和流程中。这个AI系统已经被可口可乐用上了。

奥特曼在给科技媒体Axios的声明中写道,「使用OpenAI的工具已经成为人们日常生活的一部分,这些产品正在医疗保健和教育等领域产生真正的影响,无论是协助完成日常任务、解决难题或是释放创造力。」

奥特曼特意cue到医疗健康领域,让人不禁联想到他本人和OpenAI的创业基金正在大力支持的初创Thrive AI Health,旨在提供个性化的AI健康教练。

然而,就在Axios的作者Shaun Ralston发推特宣布OpenAI的这一成就时,下面的置顶评论竟然是——「AI统治世界的邪恶计划即将来临」。

虽然「顶流」地位难以撼动,但这一年来,关于OpenAI的安全丑闻和非议就没消停过。

最近曝出的一则新闻,还扯进了Anthropic这个向来「势不两立」的老对手。

OpenAI和Anthropic的「末日测试」

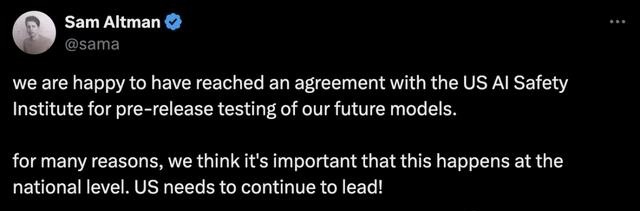

OpenAI和Anthropic分别签署了一项史无前例的协议——在发布模型之前,会先拿给美国政府进行安全测试。

奥特曼也在今天发推确认了这项合作。

我们很高兴与美国人工智能安全研究所达成协议,对我们未来的模型进行预发布测试。

出于多种原因,我们认为这在国家层面很重要。美国需要继续领先!

美国商务部下辖的国家标准与技术研究所(NIST)在新闻稿中表示,Anthropic和OpenAI均签署了一份谅解备忘录,达成与美国人工智能安全研究所的「AI安全研究、测试和评估的正式合作」。

NIST表示,这是建立在AI公司对拜登政府做出的自愿安全承诺的基础之上。

根据这项协议,AI安全研究所将在新模型公开发布之前及之后获得访问权限,并和相关公司展开合作研究。

这将确保AI领域的公共安全不只依赖于科技公司对安全风险的评估能力,以及缓解这些风险的方法。

美国AI安全研究所还将与英国的AI安全研究所合作,共同审查模型以标记潜在安全风险,向OpenAI和Anthropic提供关于其模型的潜在安全改进的反馈。

研究所主任Elizabeth Kelly称这些协议为「帮助负责任地引导AI未来发展的重要里程碑,在她看来,安全是推动突破性技术创新的关键。

这一协议的出台正值加州准备通过SB 1047法案,反映了美国各级政府和立法者对AI安全的日益关注。

Anthropic联创:AI 安全对创新「至关重要」

SB 1047旨在规范AI在加州的开发和部署,已于周三在民主党控制的州参议院上以压倒性多数通过投票。

由于进行过修改,参议院还将在本周再次投票,决定是否通过修正案,但这被认为只是「走个过场」。实际上,SB 1047只待州长批准,即可在2026年1月1日正式生效施行。

然而,加州州长Gavin Newsom尚未表明自己对法案的立场,在技术高管、风险投资家、学者和议员们展开的激烈游说中,他必须在9月30日前做出决定。

该法案最具争议的方面之一,是要求AI公司内置一个「紧急停止开关」,以防止模型引入对公共安全的新威胁,尤其是模型「在人类有限监督或干预」运行时。

据路透社报道,Anthropic是谨慎支持该法案的AI公司之一,声称在最后一轮修订后,法规的潜在好处可能超过成本。

Anthropic CEO联创兼CEO Dario Amodei在上周致州长的信中阐明了自己支持的理由。

他表示,尽管还不确定法案中「看起来令人担忧或模棱两可」的方面,但由于最近对法案的修改,Anthropic最初对该法案阻碍创新的担忧已大大减少。

Anthropic的联合创始人Jack Clark也对路透社表示,「安全、可信赖的AI对技术的正面影响至关重要。」

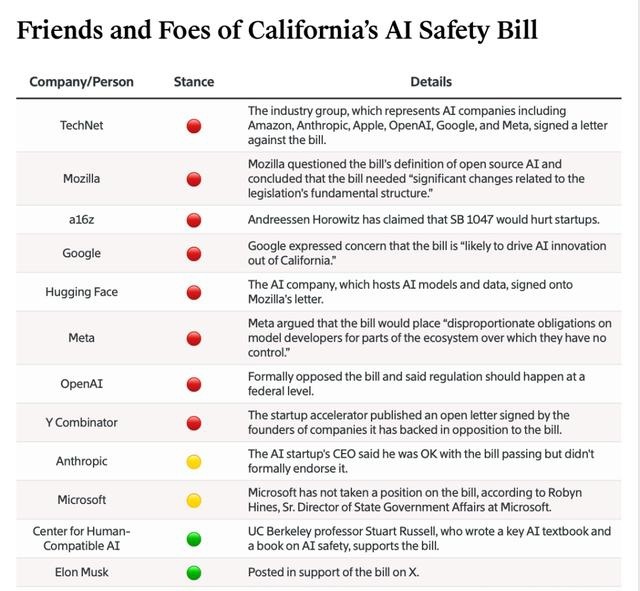

与Anthropic正好相反,OpenAI加入了反对者的阵营,并已经展开了游说。

在致法案共同发起人、加州参议员Scott Wiener的信中,OpenAI的首席战略官Jason Kwon表示,在对前沿AI模型的监管中,应该由美国政府率先带头,以考虑对国家安全和竞争力的影响。

可以看出,虽然Anthropic和OpenAI对SB 1047有截然不同的态度,但对于加强AI安全监管似乎有相似的立场,这也能解释为何这两家公司会率先与美国AI安全研究所达成协议。

正如Jason Kwon对路透社所说的,「在负责任的AI开发方面,该研究所发挥着关键作用,希望我们的合作能为世界其他地区提供一个可借鉴的框架。」

加州AI法案,让科技圈「虎躯一震」

被卷入SB 1047的利益相关方纷繁复杂,绝不止Anthropic和OpenAI这两家公司,他们各自担心和反对的理由也不尽相同。

除了Anthropic,该法案的其他支持者包括马斯克、「图灵三巨头」之二Yoshua Bengio和Geoffrey Hinton、Gary Marus、UCB教授Stuart Russell以及其他一些警告AI失控风险的团体。

反对者的阵营同样强大,不仅有OpenAI、谷歌、Meta、HuggingFace等科技公司和各种风投资本,还有AI社区的知名学者/KOL吴恩达和李飞飞。

SB 1047之所以举足轻重,让全美的科技圈都坐立不安,不仅是因为加州在AI行业的地位,更是由于美国的立法传统——加州通过的法案有时会影响其他州的立法者。

不同于OpenAI的反对理由,很多批评者认为,该法案过于「杞人忧天」——用所谓的「紧急开关」预防世界末日出现,却对Deepfake和虚假信息等众多现有的安全风险视而不见。

因此,该法案不仅会阻碍AI的创新,而且对当今AI的安全性也没有帮助。

更有争议的一点是,SB 1047要求开发者监控客户对AI技术的使用情况,并在造成伤害时承担巨额罚款——例如,如果有人入侵自动驾驶系统并导致事故,开发该系统的公司将被追责。

此外,法案中存在定义模糊的问题——AI模型「造成关键伤害,或实质上提供关键伤害的能力」时,需要为此负责。

其中,「关键伤害」被描述为大量伤亡、超过5亿美元的损失或其他「同等严重」的伤害;但开发者究竟在什么条件下会被追责、要承担什么样的责任,这些方面都是语焉不详。

致力于支持小型科技初创的私人风投a16z的普通合伙人Martin Casado敦促州长否决法案,希望他能听取众多专家的意见,因为法案的发起人Scott Wiener「基本上忽视了他们」。

吴恩达最近频频撰文呼吁,「还有时间阻止加州的SB 1047成为法律」。他认为该法案的监管重点出现了偏差,「我们应该监管有害的AI应用,而不是通用AI模型。」

开源界十分担忧

科技巨头、风投资本为自己的利益据理力争时,也有批评者站出来说,SB 1047对开源且不以盈利为目的的开发者同样不公平。

一个开源软件组织的联合创始人Chris Lengerich表示,这种不确定性意味着重大的财务影响,因为法案要求开发者雇用专门的审计员来检查他们的工作。

「公司将花费大量资金和时间去理解这些术语的含义,但实际上没有人真正清楚。」

法案的规定适用于花费超过1亿美元训练的AI模型,或花费超过1000万美元微调现有模型的开发者——很多小型的科技公司就会落入后者的范畴。

如果技术导致「对他人造成死亡或人身伤害」、「对财产造成损害」等,AI开发者将面临的罚款将是开发费用10%~30%。

一家开源AI公司的政策研究员总结道,「这意味着对财产造成任何损害都可能导致数千万美元的罚款,而不仅限于灾难性事件」。比如,黑客可能利用AI激活消防洒水器并造成水资源浪费。

除此之外,法案还要求开发者评估其模型的衍生产品并防止它们可能造成的任何伤害,包括客户微调模型、以其他方式修改模型(如越狱)或将其与其他软件组合的情况。

但问题在于,一旦开源软件发布哪些股票可融资,开发者通常无从得知其他开发者或客户的具体操作,因为人们可以直接将模型下载到个人设备上。